アクセスログは、コンピューターシステムやネットワークへのアクセス記録を詳細に記録したものです。これらのログは、システムの正常な動作を監視し、セキュリティインシデントを検知し、法的コンプライアンスを維持するために不可欠な要素となっています。応用情報技術者試験においても重要な出題分野であり、システム管理者やセキュリティ担当者にとって必須の知識です。

現代のIT環境では、あらゆるシステムコンポーネントがアクセスログを生成します。Webサーバー、データベース、アプリケーション、ネットワーク機器、セキュリティ機器など、それぞれが異なる形式と内容でログを記録し、組織の情報資産を保護するための重要な情報を提供しています。

アクセスログの基本概念と重要性

アクセスログとは、システムリソースへのアクセス試行とその結果を時系列順に記録したファイルまたはデータベースです。これらのログには、アクセス時刻、アクセス元、アクセス先、実行されたアクション、結果コードなどの情報が含まれており、システムの動作状況を包括的に把握することができます。

アクセスログの重要性は多岐にわたります。まず、セキュリティの観点から、不正アクセスや攻撃の検知と分析に欠かせません。異常なアクセスパターンや権限外のリソースへのアクセス試行を検出することで、セキュリティインシデントの早期発見と対応が可能になります。このような監視活動を効率化するために、多くの組織では専用のログ解析システムを導入しています。

運用管理の観点では、システムの性能監視、キャパシティプランニング、障害の原因究明に活用されます。アクセスログを分析することで、システムのボトルネックを特定し、リソースの最適化を図ることができます。また、法的コンプライアンスの観点から、多くの業界規制や法律によってログの保存と管理が義務付けられており、監査証跡として重要な役割を果たします。

デジタルフォレンジックにおいても、アクセスログは決定的な証拠となります。セキュリティインシデントが発生した際に、攻撃者の行動を追跡し、被害範囲を特定するために不可欠な情報源となります。このような調査活動を支援するため、フォレンジック専用ツールが広く活用されています。

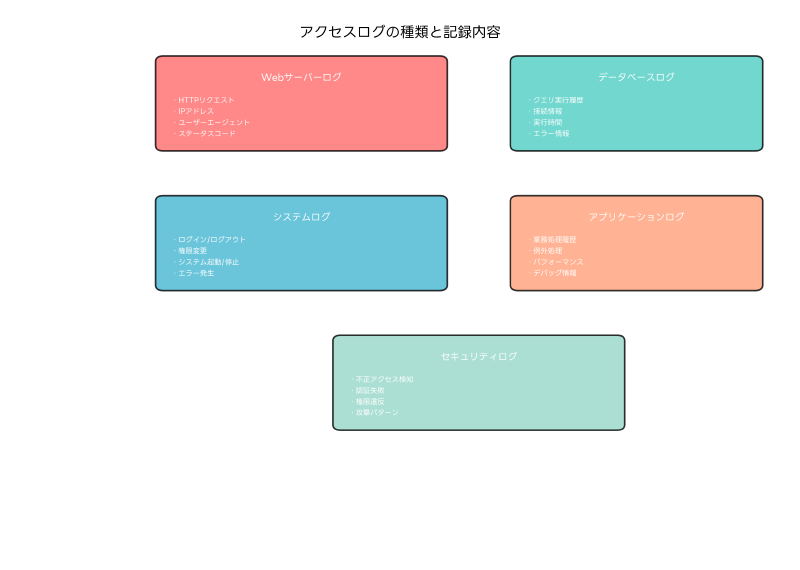

アクセスログの種類と特徴

アクセスログは、生成されるシステムコンポーネントによって様々な種類に分類されます。それぞれのログには固有の特徴があり、記録される情報の内容や形式が異なります。

Webサーバーログは最も一般的なアクセスログの一つです。Apache、Nginx、IISなどのWebサーバーが生成するこれらのログには、HTTPリクエストの詳細情報が記録されます。クライアントのIPアドレス、リクエストされたURL、HTTPメソッド、レスポンスステータスコード、転送されたデータサイズ、リファラー情報、ユーザーエージェント情報などが含まれています。これらの情報を効率的に解析するために、Webログ解析ツールが多数提供されています。

データベースアクセスログは、データベース管理システムによって生成されるログです。SQL文の実行履歴、接続情報、実行時間、影響を受けた行数、エラー情報などが記録されます。Oracle、MySQL、PostgreSQLなどの主要なデータベースシステムでは、詳細な監査ログ機能が提供されており、機密データへのアクセスを厳密に監視できます。データベースの監視を強化するために、データベース監視ソリューションの導入が推奨されます。

システムログは、オペレーティングシステムレベルでのアクセス情報を記録します。ユーザーのログイン・ログアウト、ファイルアクセス、プロセスの実行、権限の変更、システムの起動・停止などの情報が含まれます。Windows環境ではイベントログ、Linux環境ではsyslogが代表的なシステムログです。これらのログを一元管理するために、システムログ管理ツールが活用されています。

アプリケーションログは、個別のアプリケーションが生成するログです。業務処理の実行履歴、例外処理の発生状況、パフォーマンス情報、デバッグ情報などが記録されます。アプリケーションの特性に応じてカスタマイズされた形式で記録されることが多く、ビジネス固有の要件に対応した監視が可能です。

セキュリティログは、セキュリティ機器やセキュリティソフトウェアが生成するログです。ファイアウォール、侵入検知システム(IDS)、侵入防止システム(IPS)、アンチウイルスソフトウェアなどが生成するこれらのログには、攻撃の検知情報、ブロックされた通信、マルウェアの検出情報などが記録されます。これらのログを統合的に分析するために、SIEM(Security Information and Event Management)システムが広く導入されています。

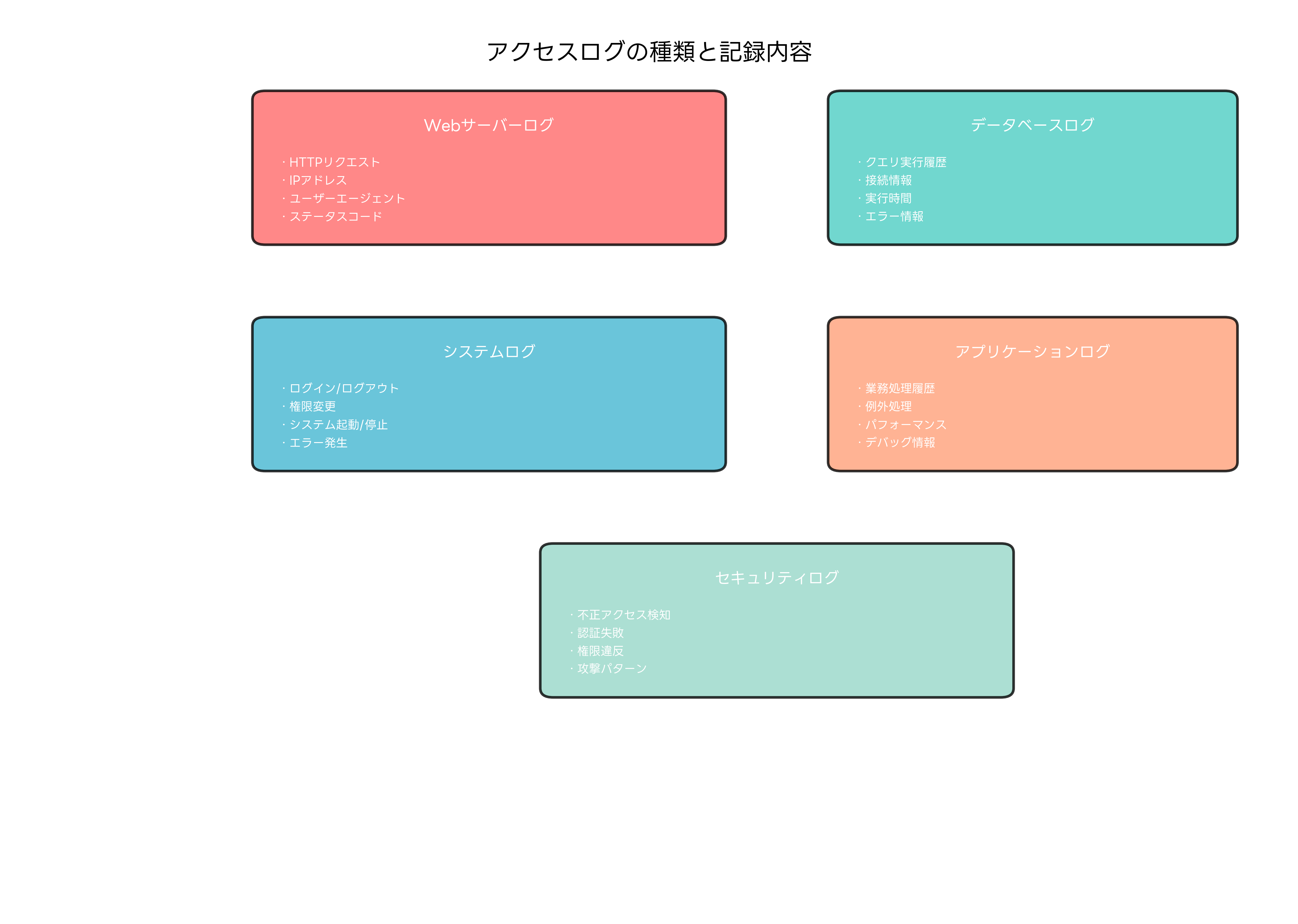

ログフォーマットの種類と特徴

アクセスログは様々なフォーマットで記録されます。フォーマットの選択は、ログの用途、解析の容易さ、ストレージ効率、互換性などの要因によって決定されます。

Apache Common Log Format(CLF)は、最も基本的なWebサーバーログフォーマットです。IPアドレス、タイムスタンプ、HTTPメソッド、URL、HTTPステータスコード、レスポンスサイズなどの基本情報が固定された形式で記録されます。シンプルで解析しやすい反面、詳細な情報が不足する場合があります。

Apache Combined Log Formatは、CLFを拡張したフォーマットです。リファラー情報とユーザーエージェント情報が追加されており、より詳細なアクセス分析が可能になります。多くのログ解析ツールがこのフォーマットをサポートしており、実用性が高いフォーマットです。

IIS W3C Extended Log Formatは、Microsoft IISで使用される拡張可能なログフォーマットです。記録する項目を柔軟に設定でき、処理時間、セッション情報、カスタムヘッダーなどの詳細情報を含めることができます。企業環境でのWindows系Webサーバーでは標準的に使用されています。

JSON(JavaScript Object Notation)形式は、構造化されたデータ表現として近年注目されているフォーマットです。階層的なデータ構造を表現でき、プログラムによる解析が容易で、NoSQLデータベースとの親和性が高いという特徴があります。現代的なログ管理システムでは、JSON形式での記録と保存が推奨されています。JSON対応ログ処理ツールを使用することで、効率的なログ解析が可能になります。

Syslog形式は、UNIX系システムで標準的に使用されるログフォーマットです。RFC3164やRFC5424で標準化されており、ネットワーク経由でのログ転送に対応しています。優先度、ファシリティ、タグなどの情報により、ログメッセージの分類と配信制御が可能です。

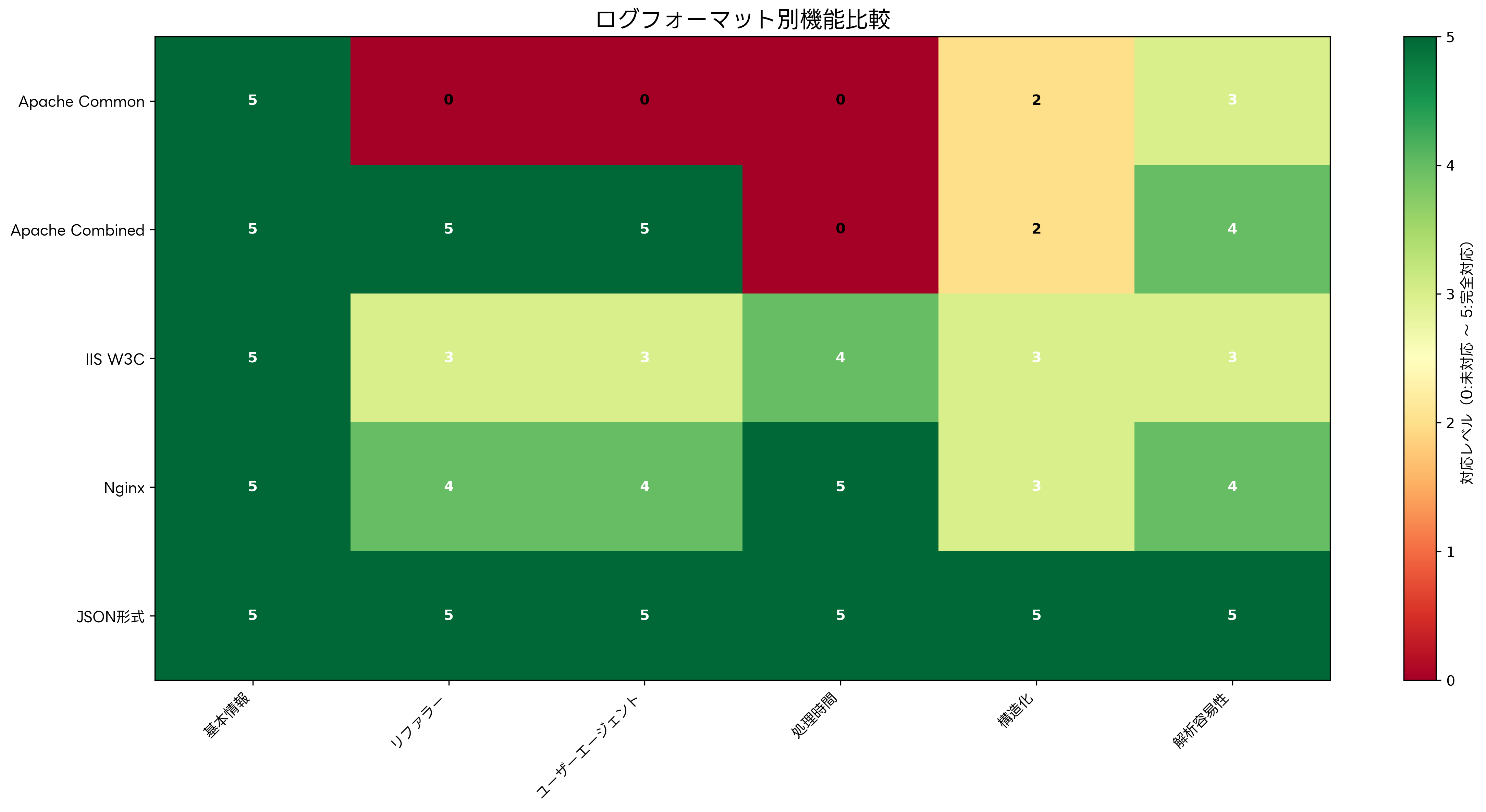

アクセスパターンの分析と異常検知

アクセスログの分析により、正常なアクセスパターンと異常なパターンを識別することができます。これは、セキュリティインシデントの検知とシステムの最適化において極めて重要な作業です。

正常なアクセスパターンは、通常、予測可能な時間的変動を示します。ビジネスアワーには高いアクセス数を示し、夜間や週末には低いアクセス数になるという周期的なパターンが一般的です。季節性や特定のイベントによる変動も含めて、ベースラインとなるアクセスパターンを確立することが重要です。

異常なアクセスパターンの検知には、統計的手法や機械学習技術が活用されます。急激なアクセス数の増加、通常とは異なる時間帯でのアクセス、特定のIPアドレスからの大量アクセス、異常に多い404エラーの発生などが異常の兆候として検出されます。これらの異常を自動的に検知するために、異常検知システムの導入が効果的です。

DDoS攻撃の検知では、アクセス頻度、リクエストパターン、送信元IPアドレスの分布などを分析します。正常なトラフィックでは見られない大量の同一リクエストや、短時間での大量アクセスが検出されると、攻撃の可能性が高いと判断されます。このような攻撃から保護するために、DDoS対策ソリューションの実装が必要です。

Webアプリケーション攻撃の検知では、SQLインジェクション、クロスサイトスクリプティング(XSS)、ディレクトリトラバーサルなどの攻撃パターンをログから識別します。これらの攻撃は、通常のWebアクセスでは見られない特殊な文字列やパターンを含むため、シグネチャベースの検知が有効です。

内部脅威の検知では、権限を持つユーザーによる異常なアクセスパターンを識別します。通常の業務時間外でのアクセス、普段アクセスしないリソースへのアクセス、大量のデータダウンロードなどが内部脅威の兆候として検出されます。このような脅威を検知するために、内部脅威対策ツールが開発されています。

ログ解析ツールとプラットフォーム

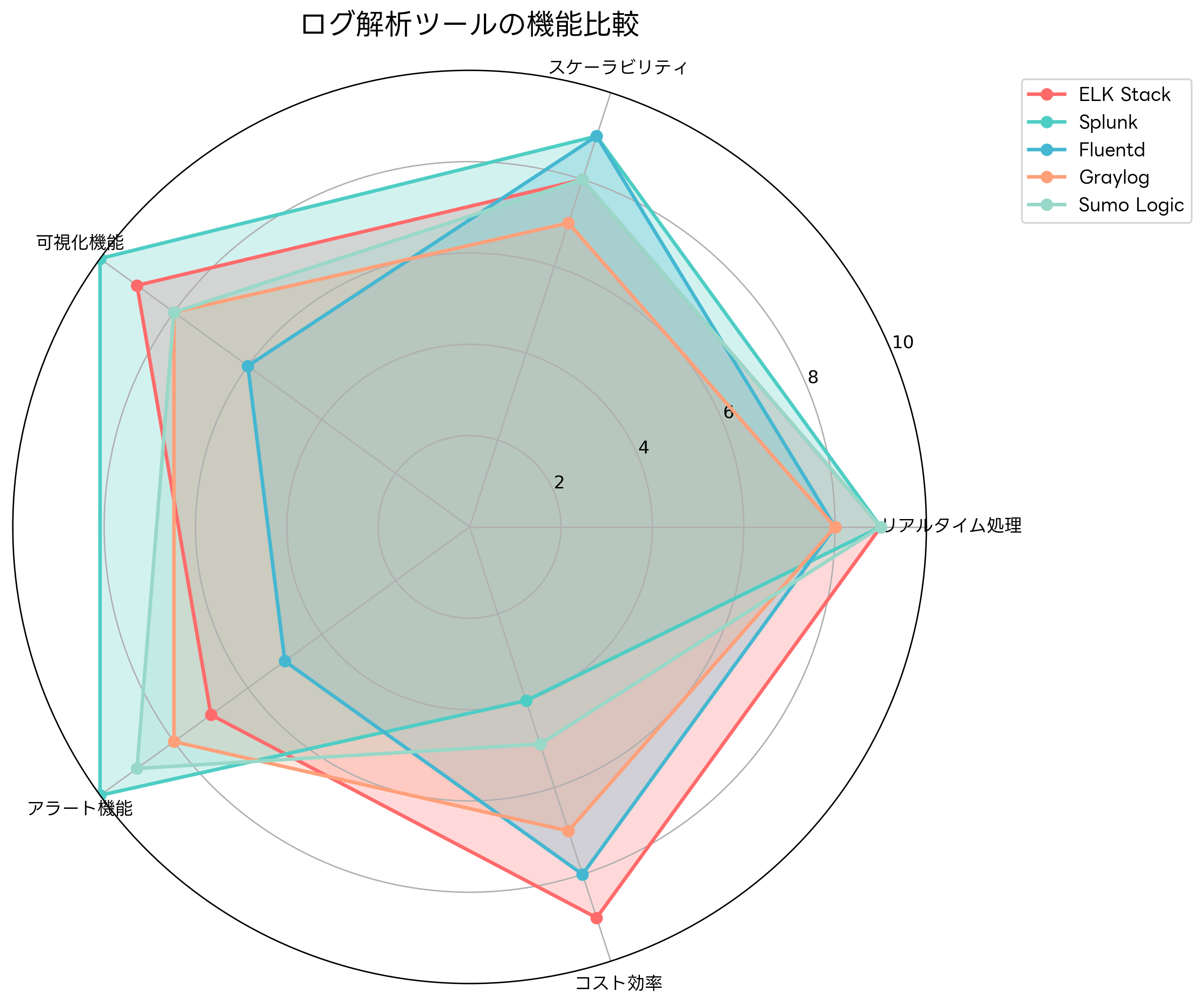

効果的なアクセスログ分析のためには、適切なツールとプラットフォームの選択が重要です。現在、多様なログ解析ソリューションが提供されており、組織の規模、要件、予算に応じて最適な選択が可能です。

ELK Stack(Elasticsearch、Logstash、Kibana)は、オープンソースのログ解析プラットフォームとして広く採用されています。Elasticsearchが高性能な検索エンジンとして機能し、Logstashがログの収集と処理を行い、Kibanaが可視化と分析機能を提供します。スケーラビリティに優れ、大量のログデータを効率的に処理できます。オンプレミス環境での構築を支援するために、[ELK Stack構築ガイド](https://www.amazon.co.jp/s?k=ELK Stack構築ガイド&tag=amazon-product-items-22)が多数出版されています。

Splunkは、商用のログ解析プラットフォームとして高い評価を得ています。強力な検索機能、豊富な可視化オプション、高度なアラート機能を提供し、エンタープライズ環境での運用に適しています。機械学習機能を内蔵しており、異常検知や予測分析が可能です。Splunkの活用を最大化するために、Splunk運用ガイドの学習が推奨されます。

Fluentdは、オープンソースのログ収集・転送ツールです。様々なデータソースからログを収集し、複数の出力先に配信できます。プラグインアーキテクチャにより、幅広いシステムとの連携が可能です。軽量で高性能な設計により、大規模なログ処理にも対応できます。

Graylogは、オープンソースのログ管理プラットフォームです。Elasticsearchをベースにしながら、より使いやすいインターフェースと管理機能を提供します。アラート機能、ダッシュボード機能、権限管理機能などが統合されており、中小規模の組織に適しています。

Sumo Logicは、クラウドベースのログ管理サービスです。インフラの管理が不要で、迅速な導入が可能です。機械学習による異常検知、リアルタイム分析、豊富なインテグレーション機能を提供します。クラウドファーストの組織に適したソリューションです。

これらのツールを効果的に活用するためには、適切なハードウェア環境の準備も重要です。大量のログデータを処理するために、高性能サーバーや大容量ストレージシステムの導入が必要になる場合があります。

セキュリティインシデント対応とログ分析

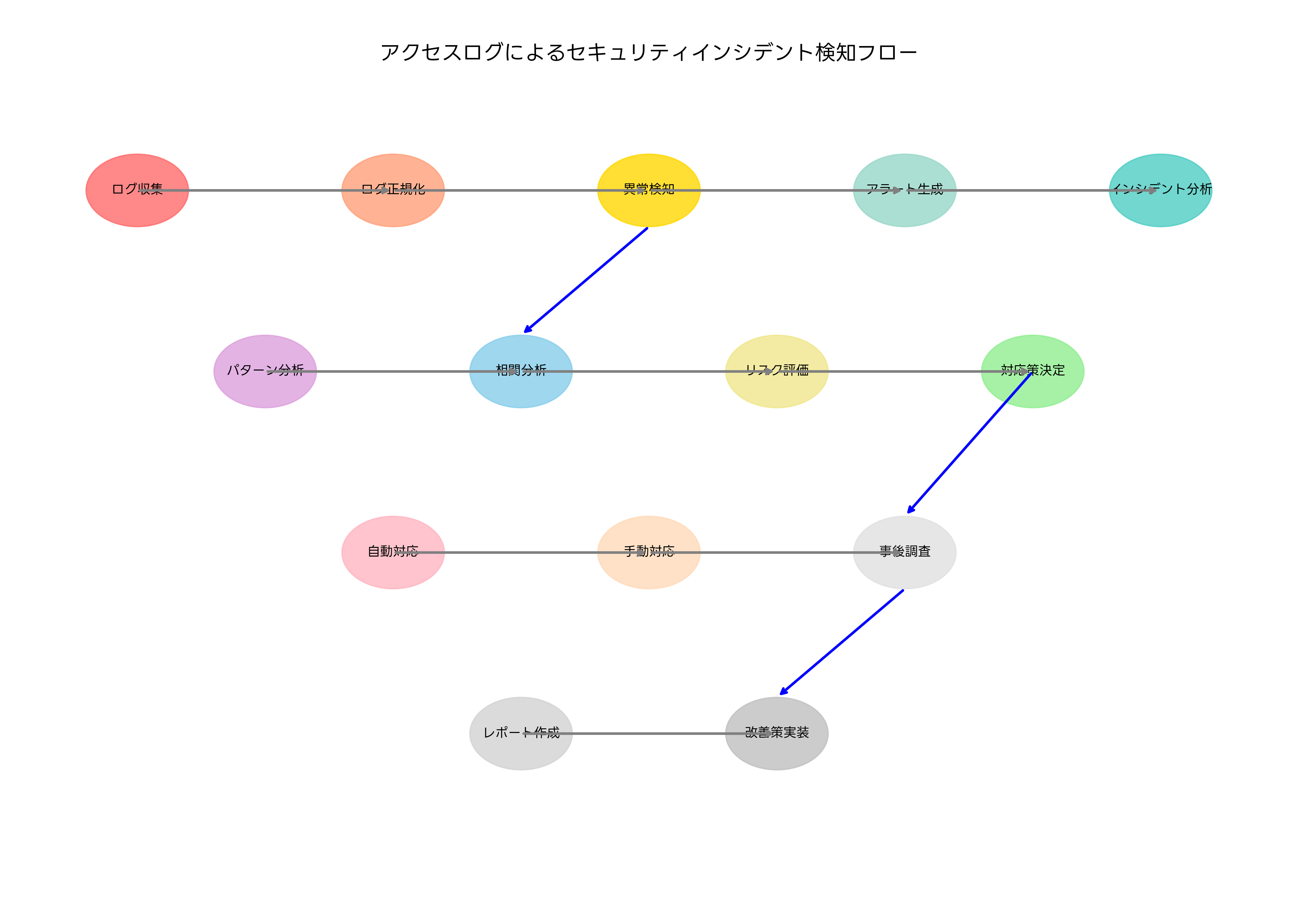

アクセスログは、セキュリティインシデントの検知、分析、対応において中核的な役割を果たします。効果的なインシデント対応のためには、体系的なアプローチとプロセスが必要です。

インシデント検知の第一段階は、リアルタイムログ監視です。SIEM(Security Information and Event Management)システムが複数のログソースからデータを収集し、相関分析を行って異常を検知します。事前に定義されたルールやシグネチャに基づいて、潜在的な脅威を識別し、アラートを生成します。効果的なSIEMシステムの構築のために、SIEM運用ガイドの参照が有用です。

インシデント分析では、検知されたアラートの詳細調査を行います。関連するログエントリを時系列で整理し、攻撃の手法、影響範囲、攻撃者の意図を分析します。この段階では、ログ分析の専門知識と経験が重要になります。分析作業を支援するために、フォレンジック分析ツールが活用されます。

脅威ハンティングは、既知の攻撃パターンだけでなく、未知の脅威を積極的に探索する活動です。仮説に基づいた分析、統計的異常の調査、IOC(Indicators of Compromise)の照合などを通じて、高度な脅威を発見します。この活動には、脅威インテリジェンスツールとの連携が効果的です。

インシデント対応では、検知された脅威に対する適切な対処を行います。自動化された対応(ブロック、隔離、アカウント無効化など)と手動対応(詳細調査、証拠保全、影響評価など)を組み合わせて、迅速かつ効果的な対処を実現します。対応プロセスの標準化のために、インシデント対応プレイブックの整備が重要です。

事後分析では、インシデントの根本原因、対応の効果性、改善点を評価します。ログデータを基にした詳細な調査により、今後の予防策と対応力向上のための知見を獲得します。この知見を組織全体で共有するために、インシデント管理システムの活用が推奨されます。

法的コンプライアンスとログ保存

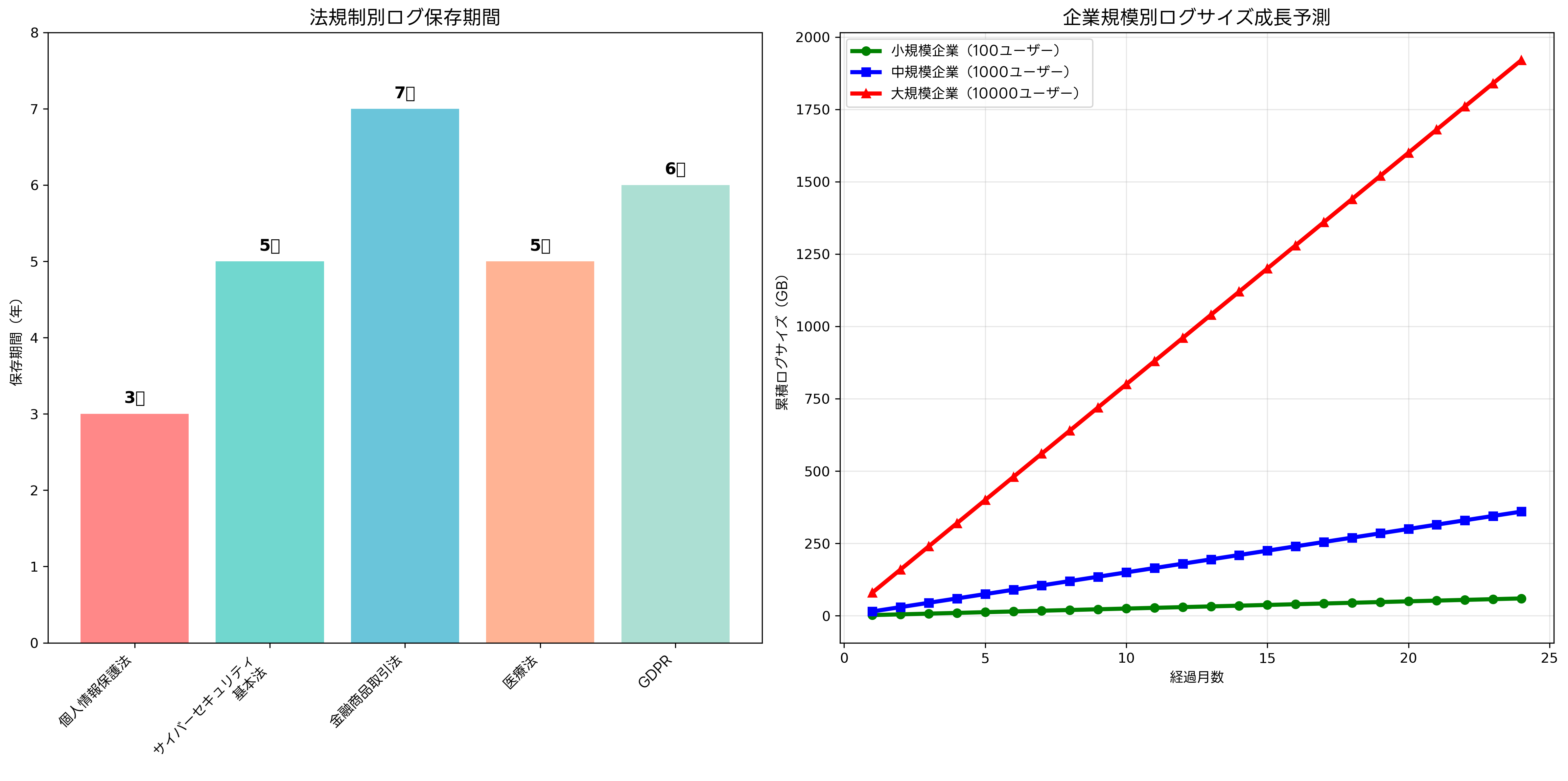

多くの業界や地域では、法律や規制によってアクセスログの保存と管理が義務付けられています。適切なコンプライアンス対応は、組織の法的リスクを軽減し、監査要件を満たすために不可欠です。

個人情報保護法では、個人情報を取り扱うシステムのアクセスログ保存が求められています。特に、個人情報への不正アクセスの監視と証跡保存が重要な要件となっています。法的要件を満たすために、個人情報保護対応システムの導入が推奨されます。

金融業界では、金融商品取引法、銀行法、保険業法などにより、厳格なログ保存要件が定められています。取引記録、顧客情報アクセス、システム操作などのログを長期間保存し、監査に対応できる体制の構築が必要です。金融機関向けのコンプライアンス管理システムが専門的に開発されています。

医療業界では、医療法、個人情報保護法、医療情報システムの安全管理に関するガイドラインなどにより、患者情報へのアクセスログ保存が義務付けられています。電子カルテシステム、医療画像システム、検査システムなどのアクセス記録を適切に管理する必要があります。

GDPR(一般データ保護規則)では、EU圏内の個人データを取り扱う組織に対して、データ処理の透明性と説明責任が求められています。個人データへのアクセス、処理、転送の記録を詳細に保存し、データ主体からの要求に応じて提供する体制が必要です。GDPR対応を支援するために、GDPR対応ツールが提供されています。

ログ保存期間の設定では、法的要件、ビジネス要件、技術的制約、コストなどを総合的に考慮する必要があります。一般的には、3年から7年の保存期間が設定されることが多く、重要度に応じて階層化されたストレージ戦略が採用されます。長期保存のために、アーカイブストレージシステムの導入が効果的です。

ログ管理のベストプラクティス

効果的なアクセスログ管理のためには、技術的な実装だけでなく、組織的なプロセスと継続的な改善が重要です。

ログ設計の段階では、記録する情報の範囲、フォーマット、保存場所、アクセス制御を慎重に検討する必要があります。過剰なログ記録はストレージコストとパフォーマンスに影響を与える一方、不十分なログ記録はセキュリティとコンプライアンスのリスクを高めます。適切なバランスを見つけるために、ログ管理ベストプラクティスガイドの参照が有用です。

時刻同期は、ログ分析において極めて重要な要素です。すべてのシステムコンポーネントで一貫した時刻を使用することで、異なるシステム間での相関分析が可能になります。NTP(Network Time Protocol)サーバーの導入により、精密な時刻同期を実現できます。高精度時刻同期システムの活用により、フォレンジック調査の精度を向上させることができます。

ログの完全性保護は、証拠能力を維持するために不可欠です。ログファイルの改ざんを防ぐために、デジタル署名、ハッシュ値の記録、書き込み専用ストレージの使用などの技術的対策を实装します。また、ログアクセスの監査により、不正な操作を検知できます。

災害復旧とビジネス継続性の観点から、ログデータのバックアップとレプリケーションが重要です。地理的に分散した複数の拠点にログを保存することで、災害時でもログデータの可用性を確保できます。災害復旧システムとの統合により、包括的なBCP対策を実現できます。

プライバシー保護の観点から、ログに含まれる個人情報の取り扱いに注意が必要です。ログ記録時の匿名化、仮名化、アクセス制御により、プライバシーリスクを最小化できます。特に、EU圏との取引がある組織では、GDPR要件を満たすためのプライバシー保護対策が必要です。

新技術とログ管理の未来

クラウドコンピューティング、人工知能、ビッグデータ分析などの新技術により、ログ管理の手法と可能性が大きく変化しています。

クラウドネイティブなログ管理では、マイクロサービスアーキテクチャ、コンテナ技術、サーバーレスコンピューティングに対応した新しいアプローチが必要です。分散システムでの分散トレーシング、構造化ログ記録、自動スケーリング対応などが重要な要素となります。クラウドログ管理ソリューションにより、これらの要件に対応できます。

機械学習と人工知能の活用により、ログ分析の自動化と高度化が進んでいます。異常検知アルゴリズム、予測分析、自然言語処理により、従来は人間の専門知識に依存していた分析作業を自動化できます。AI搭載ログ分析システムの導入により、分析精度と効率性を大幅に向上させることができます。

エッジコンピューティングの普及により、ログ生成と処理の分散化が進んでいます。IoTデバイス、エッジサーバー、車載システムなどから生成される大量のログデータを効率的に処理するための新しい技術とアーキテクチャが開発されています。

ブロックチェーン技術を活用したログの完全性保護も注目されています。分散台帳技術により、ログの改ざん防止と透明性の確保を実現できます。特に、高度なセキュリティが要求される金融機関や政府機関での導入が検討されています。

応用情報技術者試験での出題傾向

応用情報技術者試験では、アクセスログに関する問題が情報セキュリティ分野を中心に出題されています。試験対策として、理論的な知識と実践的な応用力の両方を身につけることが重要です。

午前問題では、ログの種類、フォーマット、分析手法、法的要件などの基礎知識が問われます。特に、異常検知の手法、インシデント対応プロセス、コンプライアンス要件に関する問題が頻出します。応用情報技術者試験対策書を活用して、体系的な知識を習得することが重要です。

午後問題では、具体的なログデータを分析して問題を解決する実践的な能力が評価されます。ログから攻撃パターンを識別する問題、適切な対策を選択する問題、コンプライアンス要件を満たすシステム設計に関する問題などが出題されます。

実務経験がある場合は、自社のログ管理システムを分析し、改善提案を考える練習が効果的です。また、オープンソースのログ分析ツールを実際に使用して、ログ分析の実践経験を積むことも有用です。ログ分析実践ガイドを参考にして、実践的なスキルを向上させることができます。

まとめ

アクセスログは、現代のIT環境において不可欠な要素です。セキュリティ監視、運用管理、コンプライアンス対応、フォレンジック調査など、多岐にわたる目的で活用されています。効果的なログ管理のためには、適切な技術的実装、組織的プロセス、継続的な改善が必要です。

新技術の導入により、ログ管理の可能性は大きく拡張されています。クラウド技術、人工知能、ビッグデータ分析などを活用することで、より高度で効率的なログ管理システムを構築できます。組織は、自社の要件に応じて最適なソリューションを選択し、継続的な改善を図ることが重要です。

応用情報技術者試験の観点からも、アクセスログは重要な学習分野です。理論的な知識と実践的な応用力を併せ持つことで、試験での成功と実務での活躍の両方を実現できるでしょう。