現代のソフトウェア開発において、Dockerは欠かすことのできない技術として確立されています。このコンテナプラットフォームは、アプリケーションの開発、テスト、デプロイメントプロセスを根本的に変革し、DevOpsの実践を大幅に向上させました。応用情報技術者試験においても、クラウドコンピューティングや仮想化技術の文脈で重要な出題トピックとなっています。

Dockerは、アプリケーションとその依存関係をコンテナと呼ばれる軽量で可搬性の高いパッケージに封じ込める技術です。このコンテナ化により、アプリケーションは開発環境から本番環境まで一貫した動作を保証し、従来の「私のマシンでは動く」問題を解決します。

Dockerの基本概念と仕組み

Dockerの核心は、Linux カーネルの機能である名前空間(namespaces)とコントロールグループ(cgroups)を活用したコンテナ技術にあります。名前空間により、プロセス、ネットワーク、ファイルシステムなどを隔離し、cgroupsによりリソースの制限と管理を行います。これにより、ホストOSを共有しながらも、各コンテナが独立した環境を持つことができます。

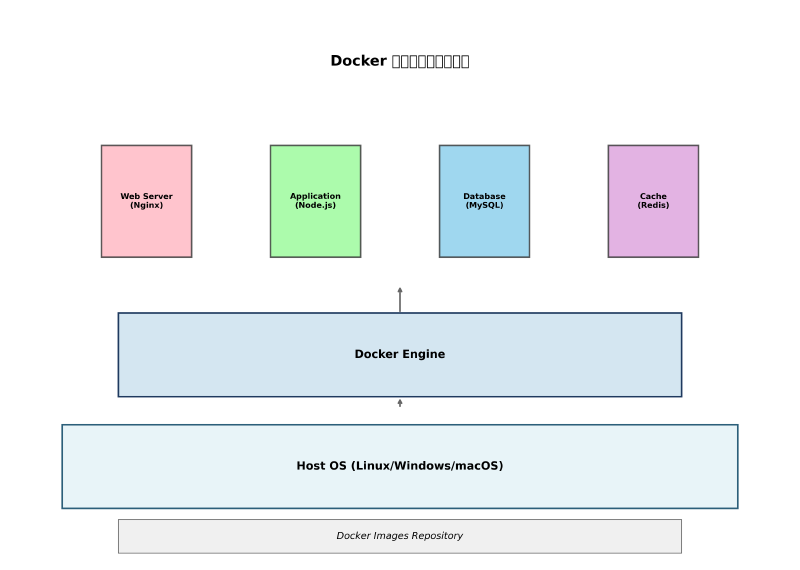

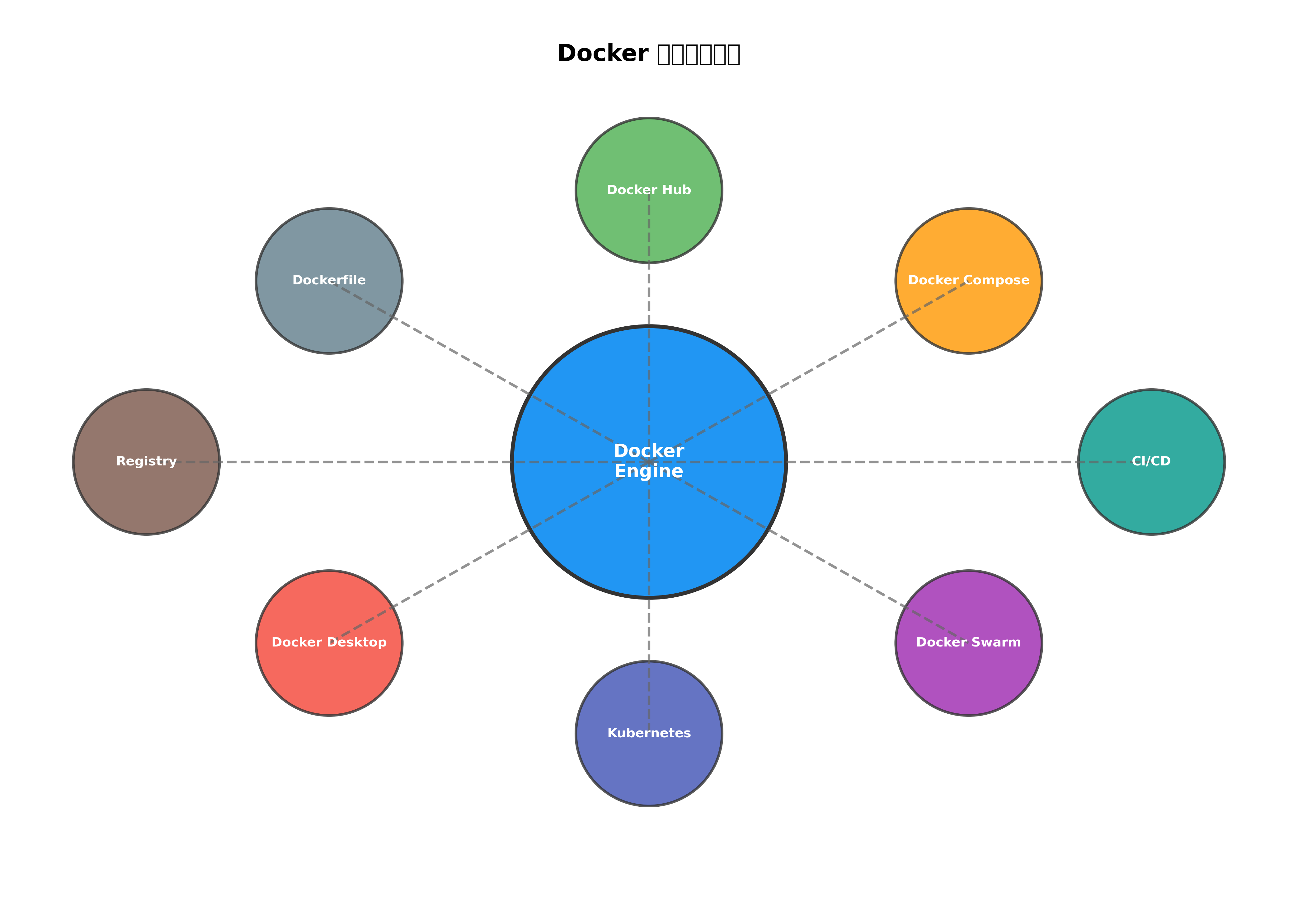

Dockerアーキテクチャは、Docker Engine、Docker Images、Docker Containers、Docker Registryの4つの主要コンポーネントで構成されています。Docker EngineはDockerの中核となるランタイムエンジンで、コンテナの作成、実行、管理を担当します。Docker Imagesは、アプリケーションとその依存関係を含む読み取り専用のテンプレートで、Docker Containersはこれらのイメージから作成される実行可能なインスタンスです。

開発環境の一貫性を保つため、多くの開発者が高性能な開発用ワークステーションや大容量SSDを使用してDockerコンテナの高速起動を実現しています。

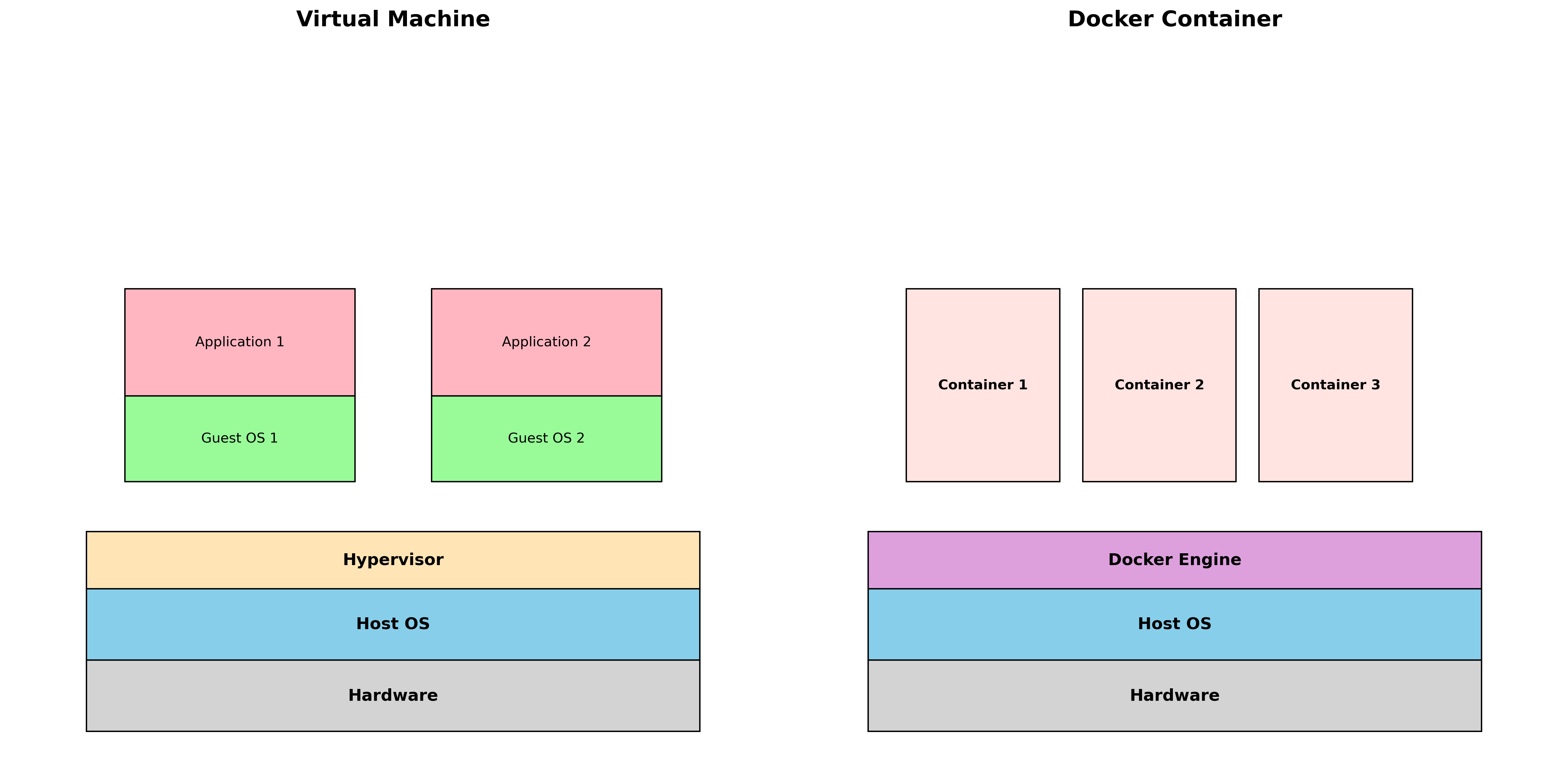

Dockerfileは、Docker Imageを作成するための設計図として機能します。このテキストファイルには、ベースイメージの指定、依存関係のインストール、ファイルのコピー、環境変数の設定など、イメージ構築に必要なすべての指示が記載されています。多層構造により、変更された部分のみを再構築することで、ビルド時間を短縮できます。

コンテナと仮想マシンの根本的な違い

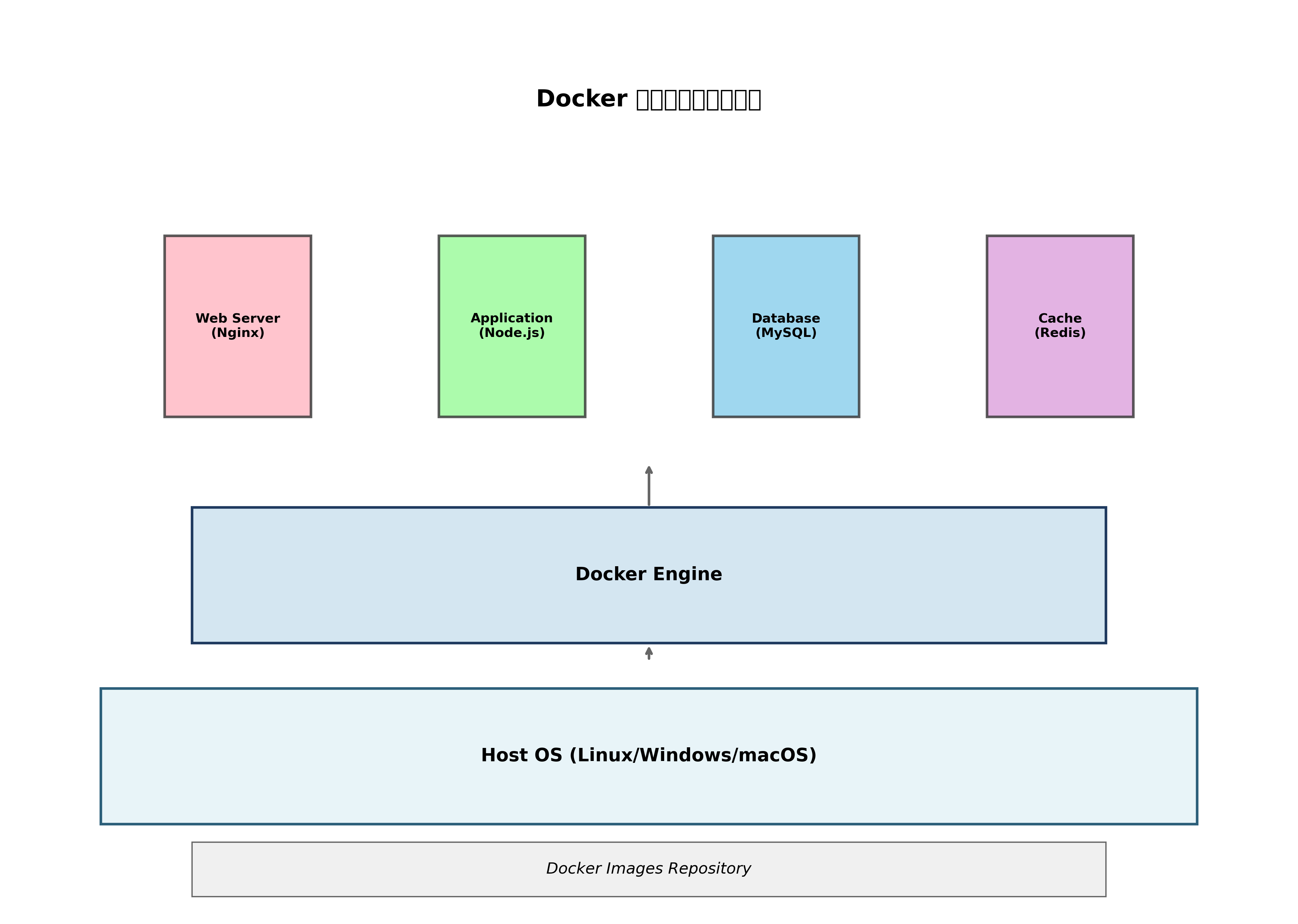

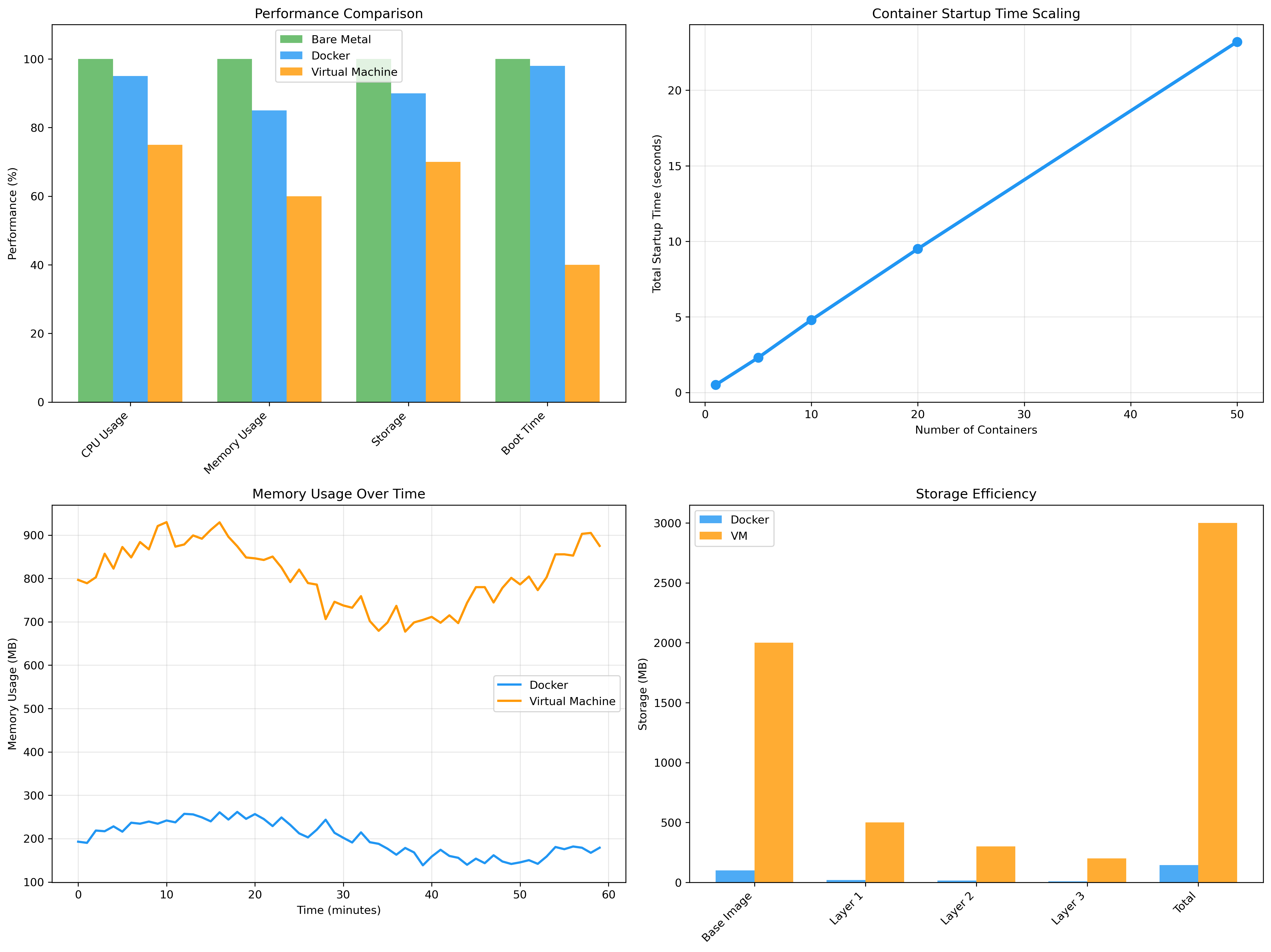

Dockerコンテナと従来の仮想マシンには、アーキテクチャ上の重要な違いがあります。仮想マシンは、ハイパーバイザー上で完全なゲストOSを実行するため、リソース消費が大きく、起動時間も長くなります。一方、Dockerコンテナは、ホストOSのカーネルを共有するため、軽量で高速に起動できます。

パフォーマンスの観点から見ると、Dockerコンテナは仮想マシンと比較して圧倒的な優位性を持っています。メモリ使用量は通常10分の1程度で、起動時間も数秒程度と大幅に短縮されます。この軽量性により、同一ハードウェア上でより多くのアプリケーションを実行でき、リソースの利用効率が向上します。

企業のインフラストラクチャでは、高性能サーバーシステムやネットワーク機器を活用して、大規模なDockerクラスター環境を構築しています。

ポータビリティもDockerの重要な特徴です。一度作成されたDockerイメージは、Docker Engineが動作するあらゆる環境で実行できます。開発者のローカル環境、テストサーバー、ステージング環境、本番環境まで、同じイメージを使用することで、環境間の差異による問題を排除できます。

セキュリティの面では、Dockerコンテナは適切に設定された場合、仮想マシンと同等のセキュリティレベルを提供できます。名前空間によるプロセス隔離、セキュリティプロファイル(AppArmor、SELinux)の活用、権限の最小化などにより、コンテナ間の干渉を防ぎます。

Docker開発ワークフローの実践

現代的なソフトウェア開発では、Dockerを中心としたワークフローが標準となっています。開発者はまずDockerfileを作成し、アプリケーションの実行環境を定義します。次に、このDockerfileからイメージをビルドし、コンテナとして起動してローカルでの開発とテストを行います。

継続的インテグレーション(CI)パイプラインでは、コードのコミットをトリガーとして自動的にDockerイメージがビルドされ、自動化されたテストが実行されます。テストが通過すると、イメージはDocker Hubやプライベートレジストリにプッシュされ、デプロイメント準備完了となります。

多くの開発チームでは、CI/CD専用サーバーや高速ビルドシステムを導入して、Docker イメージのビルドとデプロイメントプロセスを最適化しています。

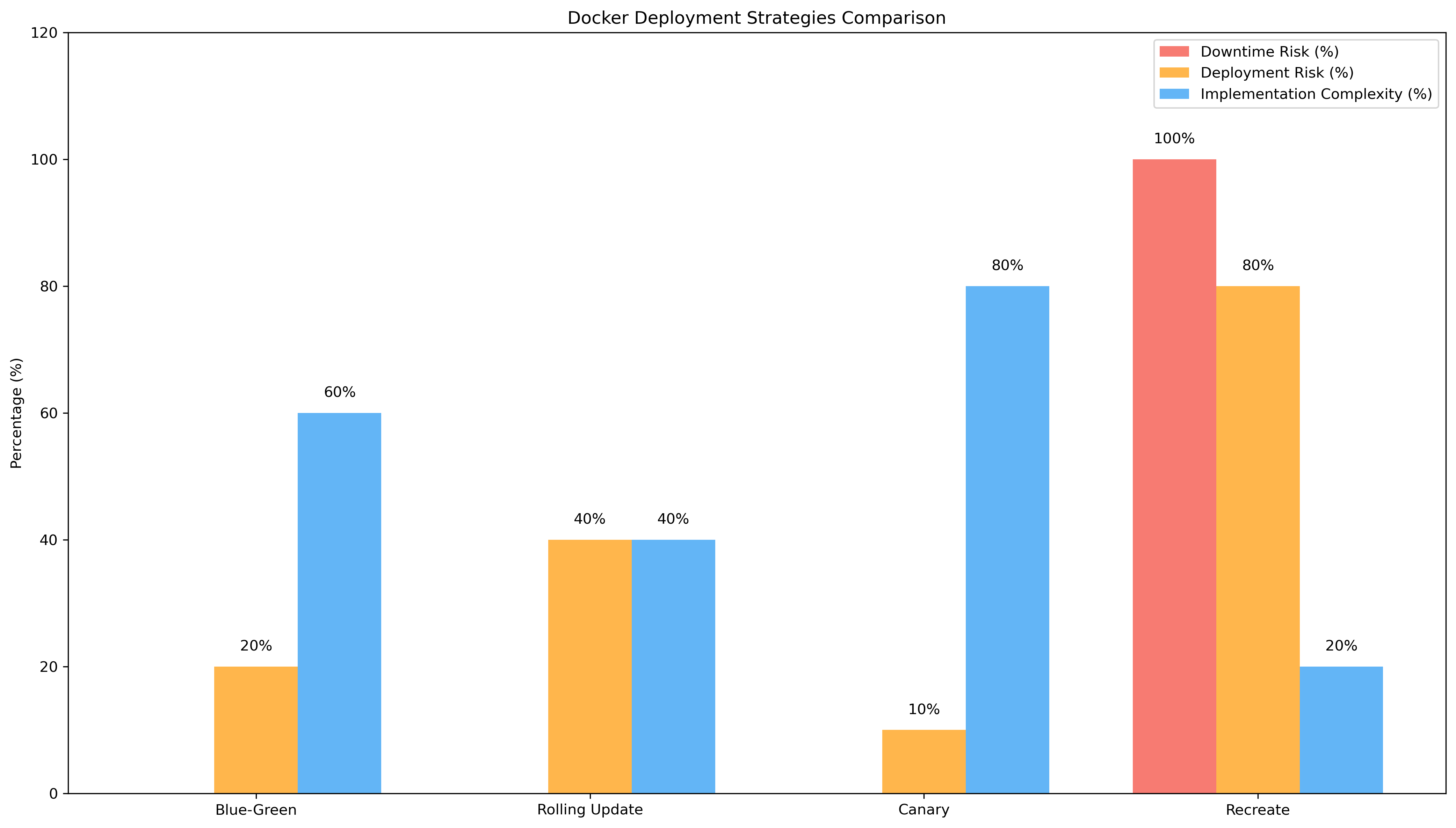

本番環境へのデプロイメントでは、Blue-Green デプロイメント、Rolling Update、Canary リリースなどの戦略が使用されます。これらの手法により、サービスの可用性を維持しながら、新しいバージョンのアプリケーションを安全にリリースできます。Dockerの軽量性により、これらの高度なデプロイメント戦略の実装が容易になりました。

マイクロサービスアーキテクチャとDockerの組み合わせは特に強力です。各サービスを独立したDockerコンテナとして実行することで、サービス間の依存関係を明確化し、スケーラビリティと保守性を向上させることができます。

Docker Composeによる複数コンテナ管理

実際のアプリケーション開発では、Webサーバー、アプリケーションサーバー、データベース、キャッシュサーバーなど、複数のコンテナを連携させる必要があります。Docker Composeは、このような複数コンテナアプリケーションの定義と実行を簡素化するツールです。

YAML形式のdocker-compose.ymlファイルに、必要なサービス、ネットワーク、ボリュームを定義することで、複雑なマルチコンテナアプリケーションを一つのコマンドで起動できます。開発環境では特に有用で、新しい開発者がプロジェクトに参加する際の環境構築時間を大幅に短縮できます。

プロダクション環境でのマルチコンテナ管理には、高可用性ストレージシステムやロードバランサーなどのインフラストラクチャが必要になることがあります。

ネットワーク管理もDocker Composeの重要な機能です。サービス間の通信を適切に制御し、セキュリティを確保しながら必要な接続のみを許可します。環境変数の管理、シークレット情報の取り扱い、ヘルスチェックの設定など、本格的なアプリケーション運用に必要な機能が包括的に提供されています。

パフォーマンス最適化と監視

Dockerコンテナのパフォーマンス最適化は、効率的なアプリケーション運用において重要な要素です。イメージサイズの最小化、適切なベースイメージの選択、多段階ビルドの活用などにより、コンテナの起動時間と実行効率を改善できます。

リソース制限の設定により、コンテナが使用できるCPU、メモリ、ネットワーク帯域幅を制御できます。これにより、一つのコンテナがシステム全体のリソースを独占することを防ぎ、安定したサービス提供を実現できます。本番環境では、サーバー監視システムやパフォーマンス測定ツールを使用して、コンテナの動作状況を継続的に監視します。

ログ管理は、Dockerベースのアプリケーションにおいて特に重要です。コンテナは一時的な性質を持つため、コンテナ内のログは適切に外部に出力する必要があります。構造化ログ、集中ログ管理、ログのアーカイブ戦略などを適切に実装することで、運用効率と問題解決能力を向上させることができます。

ストレージの最適化では、Dockerボリュームの適切な使用、一時的なファイルの管理、イメージレイヤーの効率化などが重要です。特に、データベースやファイルストレージを含むアプリケーションでは、データの永続化戦略を慎重に設計する必要があります。

Dockerエコシステムと関連技術

Dockerを中心とした豊富なエコシステムが、現代のコンテナベース開発を支えています。Docker Hub は世界最大のコンテナイメージレジストリとして、数百万のパブリックイメージを提供し、開発者の生産性向上に大きく貢献しています。

KubernetesはDockerコンテナのオーケストレーションプラットフォームとして、大規模なコンテナクラスターの管理を自動化します。自動スケーリング、サービス発見、ロードバランシング、ヘルスチェックなどの高度な機能により、エンタープライズレベルのコンテナ運用を実現します。多くの企業では、Kubernetes対応サーバーやコンテナオーケストレーション専用機器を導入しています。

Docker Swarmは、Dockerに組み込まれたシンプルなクラスター管理ソリューションです。Kubernetesほど複雑ではないものの、中小規模の環境でのコンテナクラスター運用に適しています。学習コストが低く、既存のDocker知識を活用できるため、導入のハードルが低いという利点があります。

セキュリティツールとの統合も重要な要素です。コンテナイメージの脆弱性スキャン、ランタイムセキュリティ監視、アクセス制御などを提供するコンテナセキュリティソリューションが数多く開発されています。

実践的なDeployment戦略

本番環境でのDockerコンテナデプロイメントには、ダウンタイムの最小化とリスク軽減が重要な要求事項となります。Blue-Green デプロイメントは、二つの同一環境を用意し、新しいバージョンのテストが完了後に瞬時に切り替える手法です。

Rolling Updateは、既存のコンテナを段階的に新しいバージョンに置き換える手法で、リソースの効率的な使用とサービスの継続性を両立できます。Canary リリースは、少数のユーザーに対して新しいバージョンを提供し、段階的に展開範囲を拡大する慎重なアプローチです。

これらの戦略を実装するため、企業では自動デプロイメントシステムやインフラ自動化ツールを活用しています。

災害復旧計画においても、Dockerコンテナは重要な役割を果たします。コンテナイメージのバックアップ、マルチリージョンでのレジストリレプリケーション、自動フェイルオーバーメカニズムなどにより、事業継続性を確保できます。

応用情報技術者試験での出題傾向

応用情報技術者試験では、Dockerを含むコンテナ技術が仮想化、クラウドコンピューティング、システム開発の分野で出題されます。特に、従来の仮想マシンとの比較、マイクロサービスアーキテクチャとの関連、DevOpsプラクティスとの統合などが重要なトピックです。

試験対策としては、Dockerの基本概念、アーキテクチャ、主要なコマンド、Dockerfile の記述方法、Docker Compose の使用法などを体系的に理解する必要があります。また、コンテナ化のメリット・デメリット、セキュリティ考慮事項、運用面での注意点なども出題対象となります。

実際の問題では、具体的なシナリオにおいてDockerを活用したシステム構成の選択、パフォーマンス比較、コスト分析などが求められることがあります。応用情報技術者試験対策書やクラウド技術解説書を活用して、理論と実践の両面から学習することが効果的です。

エンタープライズでのDocker活用事例

大企業でのDocker活用は、単なる開発効率化を超えて、事業戦略レベルでの影響を与えています。金融機関では、規制要件を満たしながらアジリティを向上させるため、Dockerベースのマイクロサービスアーキテクチャを採用しています。コンプライアンス要件の厳しい環境でも、適切なガバナンスとセキュリティ対策により、Dockerの利点を活用できます。

製造業では、IoTデバイスからのデータ処理、エッジコンピューティング、予測保全システムなどにDockerコンテナが活用されています。工場の環境でも動作する堅牢性と、迅速なアップデート機能により、製造プロセスの最適化と新機能の迅速な展開を実現しています。

小売業界では、季節的な需要変動に対応するため、Dockerベースの自動スケーリングシステムを構築しています。ピーク時には高性能クラウドインスタンスを自動的に追加し、需要が落ち着けばリソースを削減することで、コスト効率を最大化しています。

スタートアップから大企業まで、Dockerの導入により開発チームの生産性が大幅に向上している事例が数多く報告されています。新機能のリリース頻度の向上、バグ修正の迅速化、開発環境の統一化などの効果により、競争力の強化を実現しています。

次世代技術との統合

Dockerは、人工知能・機械学習ワークロードの実行プラットフォームとしても重要な役割を果たしています。GPUリソースの効率的な共有、機械学習モデルの配布、推論サービスのスケーリングなど、AI開発の様々な場面でDockerコンテナが活用されています。

エッジコンピューティング環境では、限られたリソースでの効率的な実行が求められるため、Dockerの軽量性が特に重要になります。エッジコンピューティング専用機器や産業用コンピュータでの Docker活用により、リアルタイム処理と運用効率を両立できます。

サーバーレスコンピューティングとの統合も進んでいます。AWS FargateやGoogle Cloud Runなどのサービスでは、Dockerコンテナをサーバーレス環境で実行でき、インフラ管理の負担を軽減しながらコンテナの利点を活用できます。

ブロックチェーン技術との組み合わせでは、分散アプリケーションの展開と管理にDockerコンテナが活用されています。ノードの迅速な展開、アップデート、スケーリングなどが容易になり、ブロックチェーンネットワークの運用効率が向上しています。

セキュリティとコンプライアンス

企業でのDocker活用においては、セキュリティとコンプライアンスの確保が重要な課題となります。コンテナイメージのスキャニング、脆弱性管理、アクセス制御、監査ログの記録など、包括的なセキュリティ対策が必要です。

コンテナセキュリティプラットフォームや脆弱性管理ツールの導入により、開発段階から本番運用まで一貫したセキュリティ管理を実現できます。

規制要件への対応では、データの暗号化、アクセスログの記録、変更管理、災害復旧計画などが重要です。金融業界や医療業界など、特に厳しい規制要件を持つ業界でも、適切な対策によりDockerの活用が可能になっています。

ゼロトラストセキュリティモデルとの統合では、コンテナレベルでの細かなアクセス制御、通信の暗号化、継続的な監視などが実装されます。これにより、従来の境界防御では対応困難な高度な脅威に対しても、効果的な防御を実現できます。

まとめ

Dockerは現代のソフトウェア開発とインフラ運用において、もはや欠かすことのできない基盤技術となっています。その軽量性、可搬性、効率性により、開発プロセスの革新、運用コストの削減、システムの可用性向上を実現しています。

応用情報技術者試験においても重要なトピックであり、仮想化技術、クラウドコンピューティング、システム開発の理解において中核的な位置を占めています。理論的な知識と実践的な経験の両方を身につけることで、現代的なIT システムの設計と運用に必要な能力を獲得できます。

技術の進歩とともに、Dockerエコシステムも継続的に発展しています。Kubernetes、サーバーレス技術、エッジコンピューティング、AI・ML ワークロードなどとの統合により、さらに多様な用途での活用が期待されます。継続的な学習と実践により、この革新的な技術を効果的に活用し、競争力のあるシステムを構築することが可能になります。